1. وهم الـ Frontend والصدمة الأولى: إيه هو الـ Backend؟

كمطور واجهات (Frontend)، حياتك بتتمحور حوالين الـ Components، الـ State، والـ UI. كتير من الـ Juniors بيشوفوا الـ Backend كأنه مجرد “بياع في سوبر ماركت”: بتطلب منه بيانات وتستناها، وكل اللي بتكتبه هو:

// تفكير المبتدئ: الـ Backend هو مجرد URL بيرجع JSON

const response = await fetch("https://api.myapp.com/users");

const data = await response.json();

setUsers(data);

الموضوع بيبان من بره بسيط، كأنه مجرد دالة fetch بتجيب بيانات، لكن الحقيقة إن السطرين دول هما قمة المدعكة حرفيا بس. الـ 5% اللي ظاهرين قدامك بيخفوا وراهم منظومة معقدة من البروتوكولات، وأنظمة الحماية، والخوارزميات اللي بتنفذ عمليات دقيقة في أقل من 50 ملي ثانية. من أكبر المفاهيم المغلوطة في البدايات إن الـ Backend مجرد Router و Controller بيعمل استعلام بسيط زي SELECT * FROM users. التفكير بالشكل ده بيحد من تطورك لأن الـ Backend الحقيقي أعمق من كده بكتير، هو بناء هندسة متكاملة بتضمن الثقة والأمان، وبتقدم أداء سريع ومستقر حتى تحت ضغط آلاف المستخدمين في نفس اللحظة.

2. الـ Mental Model: الـ Backend من المبادئ الأولى (First Principles)

ليه الـ Backend موجود أصلاً؟ وليه منعملش كل حاجة في المتصفح؟

عشان نفهم ده، لازم نرجع للقاعدة الذهبية والأولى في أمن المعلومات وهندسة النظم: “Never Trust the Client” (لا تثق أبداً في العميل). الكود اللي شغال في المتصفح (Frontend) أو على الموبايل هو كود شغال على جهاز المستخدم. المستخدم يقدر يعدله، يتلاعب بيه، أو حتى يوقفه. لو خصم الفلوس من الرصيد بيحصل في الـ Frontend، أي هاكر مبتدئ هيقدر يغير قيمة الخصم لصفر ويسرقك.

الـ Backend اتخلق تاريخياً عشان يحل 3 مشاكل رئيسية لا يمكن تجاوزها:

- المركزية والمصدر الوحيد للحقيقة (Single Source of Truth): لو عندنا 10 مليون مستخدم، كلهم لازم يشوفوا نفس الرصيد للحسابات، ونفس المخزون المتبقي لمنتج معين في نفس اللحظة.

- عزل الأسرار (Separation of Secrets): الـ Database Credentials، مفاتيح الدفع (Stripe/PayPal)، والخوارزميات السرية للشركة مستحيل تتبعت وتنزل على حاسوب العميل.

- القوة الحسابية (Compute Power): مشكلة الـ Frontend إنك محكوم بقدرات جهاز المستخدم (ممكن يكون موبايل ضعيف بـ 2GB RAM). الـ Backend بيديك رفاهية استخدام سيرفرات بـ 128 Core و CPUs خارقة لعمليات معقدة جداً في أجزاء من الثانية.

تاريخياً، الـ Backend بدأ كمجرد خادم بيرجع ملفات HTML ثابتة. لكن مع قوة الـ SPAs، تحول إلى العقل المدبر (API Server) اللي بيدير “الحالة” (State) وبيفصل قواعد العمل (Business Logic) تماماً عن الواجهة.

3. تشريح الرحلة (Technical Deep Dive): ماذا يحدث تحت الميكروسكوب؟

تخيل إنك كتبت https://api.myapp.com/users ودوست Enter. من اللحظة دي لحد ما الـ Data ترجعلك، بتحصل ملحمة هندسية معقدة:

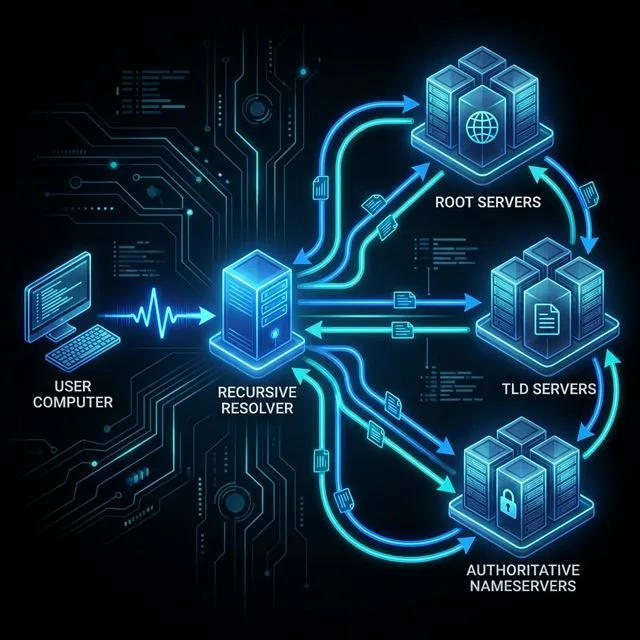

1. الـ DNS Resolution (رحلة البحث عن العنوان وتفكيك شفرة الإنترنت):

تخيل إنك رايح تقابل مديرك في مطعم، مش هينفع تقوله “هقابلك في مطعم عم محمد”، لازم تديله إحداثيات (خط طول وعرض) عشان الـ GPS يفهمها. الإنترنت بيشتغل بنفس الطريقة. أجهزة الكمبيوتر والراوترات بتفهم فقط أرقام الـ IP (إحداثيات الشبكة)، مش بتفهم أسماء زي api.myapp.com. الـ DNS (Domain Name System) هو دليل التليفونات الضخم بتاع الإنترنت اللي بيترجم الاسم اللي الإنسان بيفهمه، لرقم الـ IP اللي الآلة بتفهمه.

الرحلة دي بتتم في أجزاء من الملي ثانية، وبتمشي في مسارين: البحث المحلي (Caching)، والبحث العالمي (Recursive Resolution).

أولاً: البحث المحلي (الكاش - لأننا نكره البطء):

قبل ما جهازك يسأل العالم الخارجي، بيدور في “جيوبه” الأول بالترتيب ده:

Browser Cache: المتصفح بيسأل نفسه: “أنا زرت الموقع ده من 5 دقايق، هل الرقم لسه معايا؟”OS Cache: لو المتصفح ميعرفش، بيسأل نظام التشغيل (Windows/macOS) من خلال دالة زيgethostbyname. نظام التشغيل عنده سجل مخصص بيحتفظ فيه بالأرقام.Router Cache: لو جهازك ميعرفش، هيبعت للراوتر بتاعك في البيت، يمكن حد تاني في الشبكة فتح نفس الموقع والراوتر مخزن الرقم.ISP Resolver: لو الراوتر ميعرفش، الطلب بيروح لمزود الخدمة بتاعك (زي WE أو Vodafone). عندهم خوادم عملاقة (Recursive DNS) بتخزن ملايين العناوين عشان تسرع النت على المشتركين.

ثانياً: الرحلة العالمية (DNS Hierarchy - لو الكاش فاضي):

لو سيرفر مزود الخدمة (ISP) معندوش الرقم، بياخد هو الطلب بتاعك ويبدأ رحلة بيلف فيها العالم بالنيابة عنك (عشان كده اسمه Recursive):

- الـ Root Servers (شيوخ الإنترنت): مزود الخدمة بيروح يسأل واحد من خوادم الجذر (Root Servers - عددهم محدود جداً على مستوى العالم). السيرفر ده ميعرفش الـ IP بتاع

api.myapp.com، بس بيقوله: “أنا معرفش، بس روح اسأل السيرفر المسؤول عن الامتداد.com”. - الـ TLD Servers (خوادم النطاق الأعلى): مزود الخدمة بيروح لسيرفر الـ Top-Level Domain المسؤول عن أي حاجة بتنتهي بـ

.com. ده برضه ميعرفش الـ IP، بس بيقوله: “أنا أعرف مين السيرفر اللي اشتراه صاحب موقعmyapp.com، روح اسأله”. - الـ Authoritative Nameserver (الخادم المعتمد - محطة الوصول): أخيراً، الطلب بيوصل للخادم اللي صاحب الموقع حاطط فيه إعداداته (زي Route 53 في AWS أو Cloudflare). الخادم ده هو “صاحب الكلمة الأخيرة”، وبيفتح الدفاتر بتاعته ويرد على مزود الخدمة: “أيوه، الـ IP بتاع

api.myapp.comهو142.250.190.46”.

مزود الخدمة بياخد الرقم ده، يحفظه عنده في الكاش (عشان ميضطرش يعمل اللفة دي تاني قريب)، ويبعته لجهازك.

إيه اللي يهمك هنا معماريًا؟

- الـ Records المختلفة: إحنا مش بس بندور على A Record (وهو اللي بيشير لعنوان IPv4 القديم زي

142.250.190.46). ساعات بندور على AAAA Record (الخاص بعناوين IPv6 الأطول زي2607:f8b0:4004::67اللي اتعملت لتفادي نفاذ الأرقام). أو CNAME (رقم بيشير لاسم تاني، زي ما تعمل اسم حركي يشاور لاسمك الحقيقي). - الـ TTL (Time To Live): صاحب الموقع هو اللي بيحدد الرقم ده يفضل متخزن في الكاش عند الناس وعند مزودي الخدمة لمدة قد إيه (مثلاً 5 دقايق أو 24 ساعة). لو الـ TTL كبير وموقعك وقع، ونقلته على سيرفر جديد بـ IP جديد، المستخدمين هيفضلوا يروحوا للـ IP القديم اللي متخزن في أجهزتهم لحد ما وقت الـ TTL يخلص! عشان كده قبل ما تنقل سيرفراتك، لازم تقلل الـ TTL جداً عشان التغيير يُسمّع بسرعة في العالم كله.

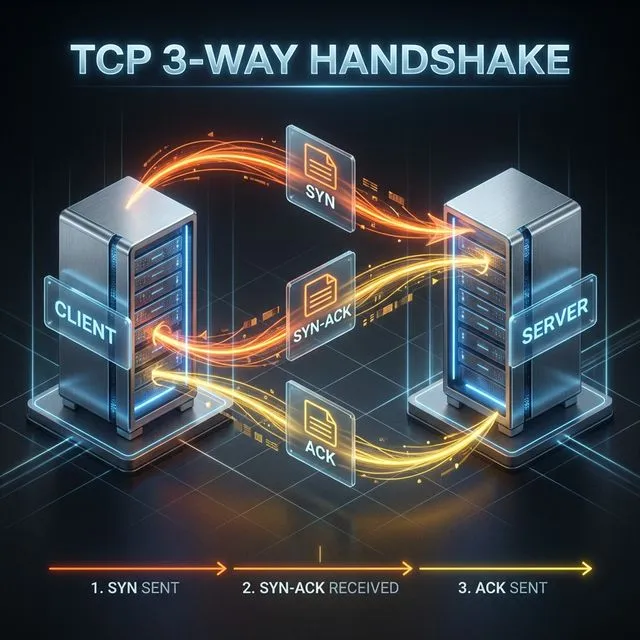

2. TCP 3-Way Handshake (بناء كوبري الثقة والموثوقية):

بعد ما عرفنا الـ IP الخاص بالسيرفر، هل المتصفح بيبدأ يرمي البيانات في الفضاء ويتمنى إنها توصل؟ أكيد لأ. الإنترنت مكان فوضوي جداً؛ الكابلات ممكن تتقطع، الـ Routers في السكة ممكن تقع، والبيانات ممكن تضيع في الزحمة. هنا بيجي دور بروتوكول TCP (Transmission Control Protocol)، وهو بمثابة “شركة شحن صارمة” بتضمن إن كل بايت هيبعته المتصفح مايوصلش بس، ده يوصل بالترتيب الصحيح وبدون أي نقص.

عشان الـ TCP يضمن الموثوقية دي، لازم السيرفر والمتصفح يبنوا “كوبري افتراضي” بينهم قبل نقل أي بيانات فعلية. العملية دي بتتسمى 3-Way Handshake (المصافحة الثلاثية)، وبتم في 3 خطوات دقيقة:

الخطوة الأولى (

SYN- التزامن): المتصفح بيبعت رسالة صغيرة للسيرفر اسمهاSYN(اختصار لـ Synchronize). الرسالة دي معناها: “ألو، أنا المتصفح وعايز أفتح معاك خط اتصال. أنا هبدأ أبعت بياناتي برقم تسلسلي عشوائي وليكن (X)”. دي خطوة لجس النبض والتأكد إن السيرفر شغال ورافع سماعة التليفون.الخطوة الثانية (

SYN-ACK- القبول والتزامن المضاد): لو السيرفر شغال وقادر يستوعب اتصالات جديدة، بيرد برسالة مزدوجةSYN-ACK. الـACK(Acknowledgement) معناها: “أنا استلمت طلبك رقم (X) وموافق عليه”، والـSYNالتانية معناها: “وأنا كمان هبدأ أبعتلك بياناتي برقم تسلسلي من عندي وليكن (Y)”.الخطوة الثالثة (

ACK- التأكيد النهائي): المتصفح بيستقبل رد السيرفر، ويبعتله رسالة أخيرةACKمعناها: “علم وينفذ، أنا استلمت رقمك (Y)”. من اللحظة دي، الكوبري اتبنى، والطرفين جاهزين يتبادلوا الداتا الفعلية (زي طلب الـ HTTP).

التكلفة المخفية (The Cost of TCP) والحلول الهندسية:

بناء الكوبري ده (الـ 3 خطوات بتاعت الـ Handshake) مش ببلاش؛ بياخد وقت بيُحسب بالـ Round Trip Time (RTT). تخيل لو كل مسج على الواتساب بتطلب منك تتصل بصاحبك، تستناه يرد، تقوله المسج، وتقفل الخط! السيستم هيكون بطيء ومستهلك للموارد جداً. عشان كده بنتدخل بحلين عبقريين للحفاظ على “كباري الـ TCP” مفتوحة:

في التواصل مع المتصفح (

HTTP Keep-Alive): زمان (في HTTP/1.0)، كان المتصفح بيفتح TCP Connection عشان يطلب ملف الـ HTML، وبعدين يقفله. وبعدين يفتح Connection جديد عشان يطلب الـ CSS ويقفله، وهكذا. ده كان دمار للأداء. دلوقتي، المتصفح بيبعت Header اسمهConnection: keep-alive. ده بيقول للسيرفر: “لو سمحت، بعد ما تبعتلي الرد، ماتهدمش كوبري الـ TCP. سيبه مفتوح شوية (مثلاً 5 ثواني) لعل وعسى أحتاج أطلب منك صور أو ملفات جافاسكريبت تانية”. ده بيوفر وقت الـ Handshake لكل الملفات اللي بتيجي بعد الـ HTML.في التواصل مع قاعدة البيانات (

Connection Pooling): تخيل إن سيرفرك (Node.js مثلاً) جاله 1000 طلب في نفس الثانية لداتا من الـ Postgres. لو مع كل طلب السيرفر راح عمل TCP Handshake جديد مع الداتابيز، الداتابيز هتقع من الإرهاق قبل ما تنفذ الـSELECTأصلاً! الـ Connection Pool هو فكرة إن السيرفر أول ما يشتغل، بيفتح مثلاً 10 كباري TCP (Connections) جاهزين مع الداتابيز، وبيسيبهم مفتوحين دايماً (زي أسطول تكاسي واقفين قدام السيرفر والمحركات دايرة). لما يجي طلب من مستخدم، السيرفر بياخد “تاكسي” فاضي من الـ Pool، ينفذ الـ Query، ولما يخلص مش بيقفل الـ Connection، بل بيرجعه تاني للـ Pool عشان الطلب اللي بعده يستخدمه فوراً بدون ما يضيع وقت في بناء Handshake جديد.

3. TLS Handshake (خوارزميات التشفير):

بما إننا شغالين HTTPS، لازم نشفر الكوبري. المشكلة الكلاسيكية: إزاي نتفق على كود تشفير مشترك من غير ما أي حد سامعنا وهو بيتحدد؟ الحل في 4 خطوات:

- السيرفر بيبعت للمتصفح Public Key (قفل مفتوح) — يعني صندوق أي حد يقدر يحط جوه حاجة.

- المتصفح بيعمل Symmetric Key (مفتاح سري سريع للتشفير اليومي).

- المتصفح بيحط المفتاح السري جوه الصندوق (بيشفره بالـ Public Key) ويبعته.

- السيرفر بس عنده Private Key يفتح الصندوق ده، فبيعرف المفتاح السري.

دلوقتي الاتنين عندهم نفس المفتاح، وكل الكلام من دلوقتي مشفر بيه. أي Man-in-the-Middle هاكر وقف في النص، هيشوف بس طلاسم لا معنى ليها.

4. البواب الكبير والدرع الواقي (Reverse Proxy & Load Balancer):

في بيئة الإنتاج (Production)، الريكويست اللي جي من المتصفح مستحيل يخبط في سيرفر التطبيق بتاعك (زي Node.js أو Python) بشكل مباشر. السيرفرات دي مصممة تنفذ قواعد العمل (Business Logic)، مش مصممة تتعامل مع فوضى الإنترنت المباشرة والاتصالات البطيئة. هنا بييجي دور الـ Reverse Proxy (زي Nginx، HAProxy، أو AWS ALB). ده عبارة عن سيرفر قوي جداً بيقف كـ “بواب عملاق” أو درع بين الإنترنت المفتوح والسيرفرات الداخلية بتاعتك. المهام اللي بيقوم بيها هي اللي بتخلي السيستم قادر يستحمل ملايين المستخدمين:

أولاً: توزيع الأحمال (Load Balancing)

لو عندك سيرفر واحد وجاله مليون طلب، هيقع (Crash). الحل إنك تشغل مثلاً 10 نسخ من السيرفر بتاعك (Horizontal Scaling). البواب هنا وظيفته يوزع الطلبات دي عليهم بذكاء عشان مفيش سيرفر يتفرم ضغط والتاني يبقى فاضي. من أهم الخوارزميات اللي بيستخدمها:

- Round Robin (التوزيع بالتناوب): بيوزع بالدور زي عقرب الساعة. الطلب الأول لسيرفر A، التاني لسيرفر B، التالت لـ C، وهكذا. حل بسيط ومناسب لو السيرفرات كلها بنفس القوة والطلبات خفيفة.

- Least Connections (الروابط الأقل): الـ Proxy بيبص مين السيرفر اللي عنده أقل عدد من الطلبات الشغالة حالياً ويبعتله الطلب الجديد. ده مفيد جداً لو في طلبات بتاخد وقت طويل للمعالجة (زي معالجة صورة) عشان ميكومش طلبات كتير على سيرفر واحد مشغول أصلاً.

- IP Hash (بصمة المستخدم): بياخد الـ IP بتاع المستخدم ويعمل عليه حسبة معينة عشان يوديه دايماً لنفس السيرفر. ده مهم لو السيرفر ده بالذات محتفظ ببيانات مؤقتة للمستخدم ده في الميموري ومش عايزينه يروح لسيرفر تاني ميعرفوش.

ثانياً: إنهاء التشفير لتخفيف العبء (SSL Termination)

في خطوة الـ TLS، عملنا Handshake لتشفير البيانات. اللي متعرفوش إن فك التشفير وإعادة تشفيره لكل طلب عملية مستهلكة جداً لقدرة المعالج (CPU Intensive). تخيل لو كل سيرفر داخلي (Node.js) اضطر يستهلك الـ CPU بتاعه في فك تشفير الرسائل، مش هيتبقى قوة كافية لتنفيذ الـ Business Logic أو الاستعلام من الداتابيز! الحل المعماري هو الـ SSL Termination: البواب العملاق (Nginx) هو الوحيد اللي بيمتلك مفاتيح فك التشفير الخاصة بشهادة الـ SSL. هو بيستقبل الطلب المشفر، يفك تشفيره (لأنه مكتوب بلغات سريعة جداً زي C ومُحسّن للعمليات دي)، وبعدين يبعت الطلب “مكشوف” (Plain HTTP) للسيرفرات الداخلية. السؤال هنا: مش خطر نبعته مكشوف؟ لأ، لأن السيرفرات الداخلية دي بتكون ورا جدار حماية وفي شبكة افتراضية خاصة (Private VPC) معزولة تماماً عن العالم الخارجي، فالبيانات بتتنقل مكشوفة بس في “أنابيب آمنة” داخل المركز نفسه، وبكده نكون وفرنا قوة السيرفرات لشغلها الأساسي ورفعنا كفاءة النظام بشكل مرعب.

5. السيرفر الداخلي (The Application Server):

الريكويست وصل لكودك، لكن قبل ما يوصل لـ Business Logic بتاعتك، بيعدي على عساكر المرور:

Rate Limiter: لو مفيش حد بيتحكم، هاكر واحد ممكن يبعت مليون طلب في الثانية ويعطل السيرفر على كل الناس التانيين (DDoS Attack). الـ Rate Limiter بيقول: “أنت بالـ IP ده مسموحلك 100 طلب في الدقيقة، زيادة عن كده ←

429 Too Many Requests”.Auth Guard (JWT):

الـ JWT Token مش مجرد رقم عشوائي. هو مقسم لـ 3 أجزاء:

header.payload.signature. الـ Payload فيه بياناتك زي{ userId: 123, role: "admin" }. والـ Signature هو توقيع رقمي بمفتاح سري موجود بس عند السيرفر. لو حاولت تغير الـ Payload وتحول نفسك لـ admin، الـ Signature مش هيتطابق، والسيرفر هيعرف إنك مزوّر. زي الباسبور: فيه بياناتك وعليه ختم رسمي مستحيل تزوره.Caching Layer (Redis):

قبل ما السيرفر يروح الـ Database، بيسأل Redis، وهي داتابيز شغالة في الـ RAM. لو لقى الرد جاهز (Cache Hit) بيرجعه في ~1ms. لو ملقاش (Cache Miss) بيروح الـ DB وبيجيب الداتا ويحفظها في Redis للمرات القادمة. لو الداتا اتغيرت، بيتعمل Cache Invalidation (مسح الـ Cache القديمة) عشان ميرجعش داتا قديمة.

Business Logic: الـ Controller بينفذ قواعد العمل ويجمع الداتا.

6. قاعدة البيانات وعلم الفهرسة (Database Indexing - إبرة في كومة قش):

تخيل السيرفر بعت Query للداتابيز بيقول: SELECT * FROM users WHERE status = 'active'. لو أرقامنا بتتكلم في 10 مليون مستخدم، الداتابيز في حالتها الطبيعية هتروح تدور فيهم واحد واحد من الأول للآخر عشان تتأكد إنها مفوتتش حد. العملية دي اسمها (Full Table Scan) ودي كابوس أداء لأي Backend، لأنها بتاخد ثواني أو دقايق كاملة وتستهلك الـ CPU والـ RAM بشكل مرعب.

هنا بيتدخل علم البيانات بخوارزمية B-Tree (Balanced Tree). الفكرة زي فهرس الكتاب بالظبط؛ بدل ما تقلب 1000 صفحة عشان تلاقي معلومة، بتبص في الفهرس المترتب أبجدياً وتعرف الصفحة فوراً. الـ Index بياخد العمود اللي بتدور بيه (زي status أو email) ويرتبه في بنية شجرة متوازنة:

[50]

/ \

[25] [75]

/ \ / \

[12] [37][62] [87]

العبقرية الهندسية وراء الـ B-Tree:

- سرعة الوصول الصاروخية (Time Complexity): الشجرة دي بتقسم البيانات لنصين مع كل خطوة (Divide and Conquer). لو بتدور على

ID=37، الشجرة هتسأل: “أنت أصغر ولا أكبر من50؟” أصغر، ننزل يسار للـ25. “أنت أكبر من25؟” أيوه، ننزل يمين نلاقي37. المليون ريكورد عشان تدور فيهم، البحث بياخد حوالي 20 خطوة فقط بـ Time Complexity قيمتهاO(log N)مقارنة بمليون خطوة في الـ Full Table Scan! - تحليل الأداء (The EXPLAIN Command): أي مبرمج قبل ما يـ Deploy الكود بتاعه بيستخدم أمر

EXPLAIN ANALYZEفي الداتابيز (زي Postgres أو MySQL) قبل الـ Query عشان يشوف المحرك هيستخدمIndex Scan(بحث سريع بالفهرس) ولاSequential Scan(بحث قاتل سطر سطر). - ضريبة الفهرسة العنيفة (The Indexing Trade-Off): هل الحل المبهر ده يخلينا نعمل Index لكل العواميد؟ إطلاقاً! الفهرس ده عبارة عن “هيكل بيانات إضافي” بيتخزن على الـ Disk وبياخد مساحة. والأخطر من كده، إنه بيُبطئ عمليات الكتابة (INSERT/UPDATE/DELETE) جداً. لأن مع كل يوزر جديد بيتسجل، الداتابيز مش بس بتحفظه في الجدول، دي بتضطر تروح تعدل الشجرة وتعملها Rebalancing (إعادة توازن) عشان تفضل المسافات بين الفروع متساوية. أنت دايماً بتعمل توازن بين تسريع الـ Reads وبطء الـ Writes.

4. التشبيه الواقعي العبقري: البنك المركزي شديد الحراسة

عشان تبني Mental Model هندسي سليم يكمل معاك طول حياتك، تخيل إن المعمار ده كله (Architecture) عبارة عن بنك دولي ضخم، وكل قطعة فيه ليها دور حاسم ومستحيل تتخطاه:

- الـ Frontend (مكنة الـ ATM في الشارع): شاشتها بتنور وبطمنك وبتقولك “جاري سحب الأموال”، بس في الحقيقة هي حتة حديدة فاضية من الفلوس الحقيقية ولا تملك أي سلطة لاتخاذ قرار. كل وظيفتها إنها واجهة استرشادية، وقاعدة الـ “Never Trust the Client” بتنطبق عليها حرفياً.

- الـ DNS (سواق التاكسي الخبير): إنت عارف اسم البنك بس مش عارف عنوانه الفعلي على الخريطة. الـ DNS هو السواق اللي حافظ شبكة الطرق بالمللي، وبياخد الاسم اللي إنت فاهمه، وبيترجمه لإحداثيات رقمية (IP) عشان يوصلك للفرع الرئيسي.

- الـ TCP & TLS (عربية نقل الأموال المصفحة): مستحيل البنك يرمي فلوسه في الشارع. الـ TCP هو العربيات اللي بتنقل الرزم بالترتيب من غير ما رزمة واحدة تقع، والـ TLS هو طاقم الحراسة المسلح والأقفال المشفرة اللي بتتغير كل ثانية عشان مفيش لصوص (Hackers) يقدروا يفتحوا الصناديق في السكة.

- الـ Reverse Proxy / Load Balancer (مدير صالة الاستقبال): البواب العبقري اللي عينه على كل الفروع في نفس اللحظة. لما يجي آلاف العملاء المشحونين، بيوزعهم بذكاء: “يا جماعة الخزنة رقم 1 زحمة وهتولع، الكاميرا جايبة إن الخزنة رقم 3 فاضية، اتفضلوا هناك”.

- الـ API Server (موظف الشباك - Teller): ده كود Node.js أو Python بتاعك. هو اللي بياخد الطلب، يتأكد من هويتك (Auth)، ويراجع الرصيد. هو مش بيمتلك الفلوس، هو بس بينفذ الأوامر واللوجيك. بس هل تفتكر إنه بينزل الخزنة العملاقة تحت الأرض يجيب الفلوس بنفسه مع كل معاملة صغيرة؟ مستحيل!

- الـ Cache / Redis (درج الفلوس الفكة اللي جنب الموظف): لو العميل بيسأل على “سعر الدولار كام النهاردة؟” أو بيسحب 100 جنيه، الموظف مش هينزل الخزنة. بيفتح الدرج السريع اللي چنبه

(RAM)ويديله الرد في جزء من الثانية(1ms). - الـ Database / PostgreSQL (الخزنة الفولاذية تحت الأرض): كنز المملكة النهائي والمحمي بأقسى درجات الأمان

(Disk). مش بننزلها إلا لو بنعمل عملية معقدة أو سحب مبالغ ضخمة وتفاصيل ماضية مش موجودة في الدرج. النزول والطلوع مكلف جداً للموارد والوقت، عشان كده لازم تحميها وتحافظ عليها بقدر الإمكان.

5. الكود بيفضح صاحبه

الفرق الحقيقي بين الـ Junior والـ Senior مش في المعرفة بلغة برمجة جديدة زي Rust أو Go، بل في العقلية (Mindset) والمسؤولية وهم بيكتبوا اللوجيك. الـ Senior بيكتب الكود وهو متخيل شكل السيرفر وهو بيولع تحت ضغط 10 آلاف مستخدم.

تعالى نأخد سيناريو بسيط: “عايزين API يرجع كل المستخدمين النشطين (Active)”.

العينة الكارثية (أو إزاي توقع السيرفر في خطوتين):

// المشاكل: Blocking Event Loop، تكديس الميموري، غياب الأمن

app.get('/users', async (req, res) => {

try {

// كارثة 1: لو الداتابيز فيها 5 مليون يوزر، السطر ده هيسحبهم كلهم ويحطهم في الـ RAM بتاعت السيرفر! (Out of Memory Crash)

const users = await db.query("SELECT * FROM users");

// كارثة 2: السيرفر (زي Node.js) شغال بـ Single Thread. الفلترة في الكود هتعمل Block للـ Event Loop، والسيرفر مش هيرد على أي حد تاني!

const activeUsers = users.filter(u => u.status === 'active');

res.json(activeUsers);

} catch (e) {

// كارثة 3: الـ Error بيترمي بكل تفاصيله للمستخدم، وده ممكن يسرب بيانات حساسة عن الداتابيز للهاكرز.

res.status(500).send(e.message);

}

});

العينة المتوسطة (Intermediate Level - فاهم أساسيات الداتابيز):

app.get('/users', async (req, res) => {

try {

// تحسن 1: الاعتماد على الـ Pagination. مستحيل الـ RAM تتملي لأننا بنسحب 10 بس كل مرة.

const { limit = 10, offset = 0 } = req.query;

// تحسن 2: رمي الشغل التقيل (الفلترة) على الداتابيز نفسها لأنها مصممة لده ومكتوبة بلغات أسرع.

const activeUsers = await db.query(

"SELECT id, name FROM users WHERE status = 'active' LIMIT $1 OFFSET $2",

[limit, offset]

);

res.json({ data: activeUsers, success: true });

} catch (error) {

// تحسن 3: رسالة آمنة لا تكشف عن تفاصيل البنية التحتية.

res.status(500).json({ success: false, message: "Internal Server Error" });

}

});

العينة المرعبة (Advanced Production-Grade Architecture):

هنا بقى بيكتب كود يقدر يعيش سنين، متأمن ضد أي هجوم، وسريع زي الطلقة.

// Controllers/user.controller.js

export class UserController {

// هندسة 1: Dependency Injection لتوزيع المهام. هنا احنا مبتكتبش كود الداتابيز مباشرة، بنديه للسيرفس عشان نقدر نعمل Unit Testing بسهولة بعدين.

constructor(userService, cacheService) {

this.userService = userService;

this.cacheService = cacheService;

}

async getActiveUsers(req, res, next) {

try {

// هندسة 2: الـ Validation الصارم. مبنثقش في أي داتا جاية من بره. بنفلترها بمكتبة زي Zod أو Joi لمنع الـ SQL Injection.

const { limit, offset } = req.validatedQuery;

// هندسة 3: تكوين مفتاح مميز للـ Cache

const cacheKey = `users:active:l${limit}:o${offset}`;

// هندسة 4: الهروب السريع! بنسأل الـ Redis الأول. لو الداتا موجودة، بنرد في 1 ملي ثانية ومبنروحش للداتابيز أصلاً.

const cachedData = await this.cacheService.get(cacheKey);

if (cachedData) {

return res.status(200).json({ data: JSON.parse(cachedData), source: 'cache' });

}

// هندسة 5: لو الـ Cache فاضي (Cache Miss)، بنروح نسحب من الداتابيز.

const users = await this.userService.fetchActiveUsers(limit, offset);

// هندسة 6: ومبننساش نحط الرد في الـ Cache لمدة 5 دقايق عشان الطلبات اللي شبهه في المستقبل القريب تتخدم بسرعة.

this.cacheService.set(cacheKey, JSON.stringify(users), { expiresIn: 300 });

res.status(200).json({ data: users, source: 'database' });

} catch (error) {

// هندسة 7: تمرير الخطأ لـ Global Error Handler عشان يوحد الردود ويسجل المشكلة في الـ Logs للـ Monitoring.

next(error);

}

}

}

- مش بيكتب كود يشتغل وخلاص. بيكتب طبقات حماية (Validation)، بيفكر في سرعة الاستجابة (Caching)، بيهتم بهيكلة المشروع للاختبار (Dependency Injection)، وبيحكم هندلته على الأخطاء.*

6. صدمة الـ Production: لما التطبيق يضرب 10,000 مستخدم في الثانية

على جهازك الخاص (Localhost)، الدنيا وردي. إنت العميل الوحيد، والسيرفر والداتابيز نايمين في نفس الـ RAM. أي كود طفولي وعشوائي هيشتغل بنجاح في لمح البصر وتفتكر إنك عملت إنجاز.

بس بمجرد ما ترفع كودك للـ Production الحقيقي (10,000 مستخدم في الثانية)، القوانين الفيزيائية بتتغير 180 درجة، واللي كان بينفع زمان هيوقعك في كوارث:

انفجار الميموري (The Memory Crash): الـ Junior متعود يكتب كود بيسحب الداتا كلها من الداتابيز أو يقرأ ملف كامل ويحطه في متغير واحد عشان يبعته. المشكلة؟ لو إنت بتحاول تبعت ملف مساحته 2GB وسيرفرك راماته 1GB، السيرفر هيتشل ويعمل

Out of Memory Crashويموت فوراً. الحل الهندسي (Streams & Buffers): الهندسة هنا إنك متخزنش الداتا في الميموري وتقف. السيرفر المحترف بيشتغل بـ Streams.. بياخد الداتا حتة بحتة (Chunks)، يقرأ الحتة، يبعتها للمستخدم، ويمسحها من الميموري فوراً وبعدين يجيب اللي بعدها. بالطريقة دي، تقدر تبعت فيلم 100GB وإنت شغال على سيرفر راماته 512MB بس وميقعش!عنق زجاجة الطابور (Connection Pool Bottleneck): فاكر التكلفة العالية بتاعت الـ (TCP 3-Way Handshake) اللي اتكلمنا عليها في إنشاء الاتصال؟ تخيل لو عندك 10 آلاف عميل دخلوا فجأة، وكل ريكويست بيحاول يبني كوبري TCP جديد (يفتح اتصال) مع الداتابيز. الداتابيز هتنهار من كتر محاولات فتح الأبواب وهترفض ترد على أي حد. الحل الهندسي (Connection Pool): العقلية الإنتاجية بتوفر مسبح اتصالات دائم. السيرفر بيفتح مثلاً 100 خط اتصال بس، بيفضلوا مفتوحين 24/7. الـ 10,000 عميل بيقفوا في طابور سريع جداً (خارج الداتابيز)، وأول ما خط من الـ 100 يفضى الريكويست بياخده، يخلص شغله في ملي ثانية، ويسيبه للي بعده. ده بيضمن إن الداتابيز متشيلش أكتر من طاقتها وتفضل سريعة.

مواجهة الغابة المظلمة (الأمان الشرس): على جهازك إنت لوحدك.. في الـ Production السيرفر متشاف لروبوتات المافيا وسكريبتات الفدية اللي بتهاجمك كل ثانية. لازم تبني أسوار منيعة:

- الـ CORS: ده زي البواب اللي معاه ليسته بـ “النطاقات - Domains” المسموح لها تكلم الـ API بتاعك. لو موقع هاكر غريب حاول يطلب الداتا، الـ CORS هيقفل في وشه الباب ويحميك من سرقة البيانات من متصفحات التانية.

- الـ Rate Limiting: ده الدرع اللي بيحميك من هجمات الحرمان من الخدمة (DDoS). لو في IP عشوائي طمع وبعت 500 طلب في ثانية عشان يخمن باسووردات أو يوقع السيرفر، الدرع بيقفشه ويحدفله

429 Too Many Requestsمن قبل ما يشم ريحة الداتابيز.

7. المنظور المعماري (The Architecture Perspective)

أكبر كذبة في الـ Backend إن السيرفر ده جهاز واحد قوي جواه كل حاجة. الحقيقة إن السيرفر المحترم عبارة عن جيش مقسّم لطبقات (Layers)، كل طبقة ليها تخصص دقيق بتحمي اللي وراها:

دروع الحافة (Edge Layer - CDN): تخيل كشك حراسة متقدم على حدود البلد. خدمات زي (Cloudflare أو AWS CloudFront) بتعمل حاجتين: أولاً، بتمتص ضربات الـ DDoS المميتة قبل ما توصل السيرفر بتاعك أصلاً. ثانياً، بتخزن الملفات الثابتة (الصور والـ CSS) في سيرفرات قريبة من بيت المستخدم (Edge Nodes). يعني المستخدم اللي في مصر بيحمل الصورة من سيرفر في مصر، ومبيعديش المحيط عشان يوصل لسيرفرك اللي في أمريكا!

بوابة التوزيع (Load Balancer / API Gateway): لما آلاف الطلبات بتعدي من الـ CDN وتوصل عندك، مستحيل سيرفر واحد يستحمل. هنا بيقف الـ Load Balancer كمدير مرور عبقري. شايف السيرفر الأول زحمة والـ CPU بتاعه 90%؟ يحدف الطلب للسيرفر التاني الفاضي. وفي الشركات الكبيرة، الـ API Gateway هو اللي بيراجع التيكت (Authentication) قبل ما يدخلك.

كتيبة المشاة (The Application Tier): ده الكود بتاعك (Node.js/Go/Python). دي الطبقة الوحيدة اللي بنقدر نعملها Horizontal Scaling (توسع أفقي) بسهولة. يوم البلاك فرايداي والزحمة نار؟ بنستنسخ من السيرفر بتاعك 50 نسخة في ثواني. يوم التلات الفجر والموقع فاضي؟ بنقتل 48 نسخة ونخلي 2 بس عشان نوفر فلوس السحابة (Cloud Costs). السيرفرات دي Stateless، مبتفتكرش حاجة، مجرد آلات حاسبة بتنفذ أوامر وتتقتل.

ذاكرة العضلات الصاروخية (The Caching Layer): ليه أنزل أسأل الداتابيز البطيئة عن “عدد المنتجات في المتجر” مع كل يوزر يدخل؟ الـ Redis هنا هو الدرج اللي جنب إيد الـ Application Tier. بيشيل المعلومات المتكررة والعمليات المعقدة اللي اتحسبت قبل كده، ويرد في

1msبس. الـ Cache هو سر السرعة في أي سيستم كبير.قلعة الملك (The Data Tier): الداتابيز (Postgres/MySQL) هي أقدس حاجة في السيستم. الـ Frontend تافه، والـ Application Servers مجرد نسخ بنرميها ونجيب غيرها، مس لكن لو الداتابيز وقعت أو الداتا باظت.. الشركة كلها بتفلس. عشان كده الطبقة دي معزولة في شبكة داخلية (Private VPC) مش متوصلة بالإنترنت المباشر أصلاً، وعليها حراسة صارمة، وبنعملها Backups كل شوية، والتعامل معاها بأسلوب “متسألنيش سؤال غبي أنا مش فاضية”.

8. ساحة الاختبار (The Crucible)

عشان نضمن إن الـ Mental Model بتاعك انطبع صح، دي أسئلة ومواقف مستوحاة من انترفيوهات الـ Senior وخناقات الـ War Rooms في الشركات الكبيرة:

أ) أسئلة الانترفيو القاتلة (Deep Reflection)

- لغز الميموري المجهول: لو الداتابيز بتاعتك استجابتها بقت بطيئة جداً لأي سبب، فجأة لاقيت الـ RAM والـ CPU بتع السيرفر (زي Node.js) بتاعك بيضربوا في السقف رغم إن السيرفر معلهوش أي عمليات حسابية معقدة وهو بس “مستني” رد الداتابيز! تفتكر إيه اللي بيحصل في الـ Event Loop والميموري بيخلي السيرفر يخنق نفسه كده؟ وإزاي تحميه؟

- ** إجابة الـ Senior:** السيرفر بيستقبل آلاف الطلبات ومش بيعملها Block (لأنه شغال Asynchronous)، فبيفتح لكل طلب مساحة في الـ الميموري ويقوله “استنى الداتابيز ترد”. مع بطء الداتابيز، الطلبات دي بتتراكم في الـ RAM ومبتخلصش والميموري بتتملي. هنا بيتدخل مكنسة السيرفر (Garbage Collector) بشكل عنيف عشان يلاقي أي مساحة فاضية يمسحها، وده اللي بيخلي CPU يضرب 100% والسيرفر يخنق نفسه! الحماية: لازم تضيف

Timeoutلأي اتصال بالداتابيز (لو مردتش في 5 ثواني اقفل الطلب فوراً)، وتعملCircuit Breakerيوقف إرسال طلبات جديدة ليها وقت أزمتها.

- ** إجابة الـ Senior:** السيرفر بيستقبل آلاف الطلبات ومش بيعملها Block (لأنه شغال Asynchronous)، فبيفتح لكل طلب مساحة في الـ الميموري ويقوله “استنى الداتابيز ترد”. مع بطء الداتابيز، الطلبات دي بتتراكم في الـ RAM ومبتخلصش والميموري بتتملي. هنا بيتدخل مكنسة السيرفر (Garbage Collector) بشكل عنيف عشان يلاقي أي مساحة فاضية يمسحها، وده اللي بيخلي CPU يضرب 100% والسيرفر يخنق نفسه! الحماية: لازم تضيف

- سحر الـ Stateless: إزاي الـ API بتاعك بيقدر يحلف ميت يمين إنه متأكد إن اليوزر ده هو “أحمد” وبيدخله على بياناته السرية فوراً عن طريق الـ JWT، رغم إن السيرفر أصلاً معندوش أي ذاكرة (Stateless) ومسجلش اسم أحمد ده في أي حتة جوا الرامات بتاعته؟ إيه هي الخدعة التشفيرية ورا ده؟

- ** إجابة الـ Senior:** الخدعة كلها في “التوقيع الرقمي” (Signature). السيرفر أول مرة سجل أحمد، كتب بياناته في التوكن وختمها بـ “سر مركزي” (Secret Key) مفيش حد في الكون يعرفه غير كود السيرفر. لما أحمد يبعت التوكن تاني، السيرفر مش بيدور في أي داتابيز! هو بس بياخد الداتا ويختمها بنفس السر ويقارن: “هل الختم اللي إنت جايبه مطابق للختم اللي أنا لسه حاسبه؟” لو متطابق، يبقى مستحيل حد يكون لعب في الداتا، وبيدخلك في 0.1 ملي ثانية. دي رياضيات وتشفير (Cryptography)، مش حفظ في الميموري.

- لغز المليون طلب: لو الـ API بتاعك بيوزع أسعار الذهب، والأسعار دي بتتحدث من البورصة كل 5 دقايق. إزاي كمهندس واعي تقدر تخلي سيرفر بامكانيات “آلة حاسبة صغيرة” يخدم مليون مستخدم في الثانية الواحدة بيسألوا عن السعر، من غير ما السيرفر يولع ولا الداتابيز تقع؟

- ** إجابة الـ Senior:** السر في طبقات الـ Caching. طالما السعر ثابت في 5 دقايق دول، مستحيل أخلي السيرفر بتاعي ينادي الداتابيز مليون مرة. المهندس البارع هياخد الرد مرة واحدة ويحفظه في طبقة الـ Edge (زي AWS CloudFront أو Cloudflare CDN) بـ Header بسيط:

Cache-Control: max-age=300. المليون شخص اللي بيعملوا Refresh وكل البوتات هياخدوا الرد فوراً من سيرفرات Cloudflare الموزعة حول العالم القريبة منهم، ومفيش أساساً ولا ريكويست واحد هيوصل للسيرفر التعبان بتاعي! شيلنا الحمل كله على كتاف الـ CDN.

- ** إجابة الـ Senior:** السر في طبقات الـ Caching. طالما السعر ثابت في 5 دقايق دول، مستحيل أخلي السيرفر بتاعي ينادي الداتابيز مليون مرة. المهندس البارع هياخد الرد مرة واحدة ويحفظه في طبقة الـ Edge (زي AWS CloudFront أو Cloudflare CDN) بـ Header بسيط: